(TF)² #16 – AI-årskrönika 2025/26 - Del 1: Vad hände?

Förra året skrev jag att 2025 var upplagt för att bli agenternas år. Det sade även Nvidia och DeepMinds grundare Demis Hassabis. I bemärkelsen att alla nu har hört talas om dem och att många företag experimenterar med dem så stämmer det, men det är nog 2026 som gör dem användbara.

Jag skriver denna krönika i två delar. Denna del handlar om var vi står och vad som hände 2025, och i del 2 som kommer nästa vecka så tittar jag på vad jag tror händer 2026. Som vanligt är den kärleksfullt handskriven, som vore det 1995, eftersom jag tänker att ni redan får nog med AI-slop (årets ord 2025, enligt Merriam-Webster!). Jag hoppas det känns på bouquetten!

2025 började starkt

Året började som ett riktigt AI-nyhetsår. Den 20 januari tillträdde Trump som USA:s president. Dagen efter utlyste han Stargate Project: $500 miljarder i privata investeringar från OpenAI, Oracle och SoftBank i AI-infrastruktur. Hypen var löjlig, med tanke på att projektet var planerat sedan 2022 och att pengarna egentligen var en möjlig plan för 2029 och att det fram till dess handlar om $100 miljarder som OpenAI och Microsoft sedan tidigare planerat, men som de ännu inte har backning för. I augusti rapporterade Bloomberg att projektet inte ens hade startat, men under hösten kom eventuellt de första riktiga investeringarna.

Sedan, i slutet av januari, släppte det kinesiska bolaget DeepSeek sin R1-modell som öppen källkod. Den var i närheten av OpenAIs bästa reasoning-modell men var tränad på en hårdvarubudget som var en tiondel av konkurrenternas. Marknaden fick panik. Nvidia tappade $500 miljarder i marknadsvärde. Hela narrativet om att USA hade ett oöverkomligt försprång tack vare hårdvarudominans ifrågasattes. DeepSeek hade visserligen tränat på smugglade Nvidia-chip som bröt mot amerikanska exportrestriktioner, men poängen att Kina kunde konkurrera kvarstod. En viktig del av den amerikanska politiska diskursen sedan dess har handlat om man borde tillåta Nvidia att sälja sina mest avancerade chip till Kina eller inte.

Hur gick förutsägelserna?

"Google släpper inte taget om AI-ledningen"

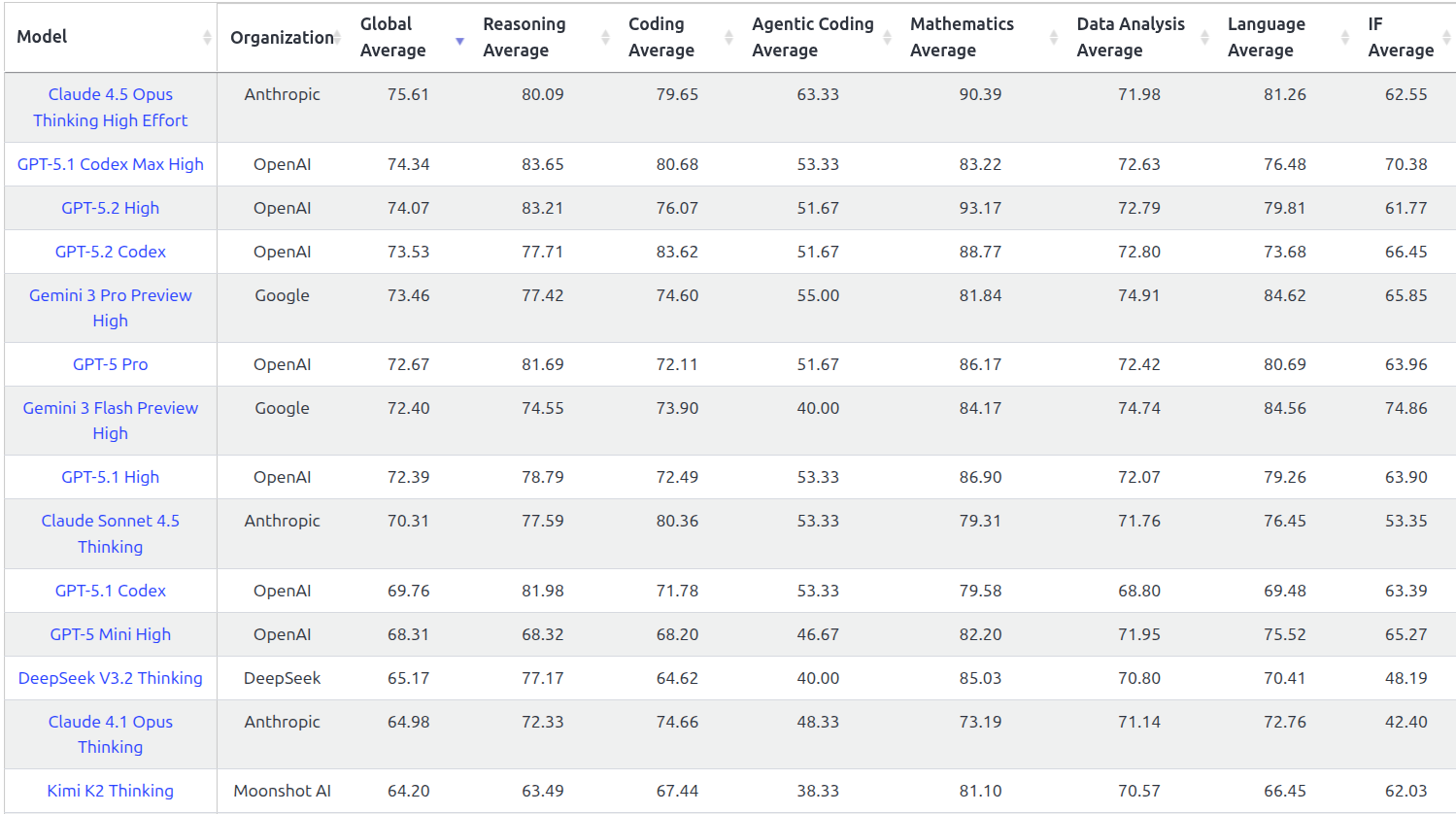

Sisådär halvrätt, även om det är en delad ledning. Gemini 3 som släpptes i november är genuint imponerande och de dominerar fortfarande bild- och videogenerering på LMArena. Men "textintelligens" och programmering? Där är det jämnare. Anthropic, OpenAI och xAI är fullt konkurrenskraftiga, och Claude Opus 4.5 toppar de viktigaste listorna i skrivande stund.

"GPT-5 försenad och inte så mycket bättre"

Rätt. Den kom i augusti, efter att ha varit försenad från december 2024 via april 2025. När den väl släpptes var reaktionen... blandad. Folk hade väntat så länge och OpenAI hypeade så mycket att förväntningarna var orimliga. GPT-5 är bra; mycket smartare, mindre insmickrande och färre hallucinationer, men den var inte det paradigmskifte som de hypeigaste influerarna lustade efter.

"Feedback på output redan under själva träningen är en viktig nyckel"

Rätt och detta tänker jag vara extra mallig över! Det visade sig vara exakt vad som hände. DeepSeeks GRPO-teknik, Googles och OpenAIs reasoning-modeller som vann guldmedalj i Matte-OS, hela trenden mot reinforcement learning från verifierbara resultat. Allt detta handlar om att låta modellen lära sig genom att få automatisk feedback på sina svar, inte bara genom att läsa text. Det har varit årets viktigaste tekniska tema och det är den delen av träningen som nu tar längst tid och är dyrast. De olika AI-företagen har ungefär samma textdata att tillgå, men när det kommer till hur de sätter upp sina virtuella miljöer där modellerna kan agera och få feedback så kan AI-modellerna få väldigt olika specialisering och känsla.

"Anthropic släpper en CoT-modell baserad på Sonnet eller Haiku"

Rätt. Claude 3.7 Sonnet kom i februari med hybrid reasoning. Sedan exploderade det: Sonnet 4 och Opus 4 i maj, Sonnet 4.5 i september, Haiku 4.5 i oktober, Opus 4.5 i november. Anthropic gick från $1 miljard till över $5 miljarder i intäkter på åtta månader.

"Meta och DeepSeek släpper öppna alternativ"

Rätt. DeepSeek överträffade alla förväntningar. R1 i januari var en chock för vissa: en reasoning-modell som hade prestanda jämförbar med OpenAI:s o1, tränad till en bråkdel av kostnaden. Det raderade $500 miljarder från Nvidias marknadsvärde på en dag. Trump kallade det ett "wake-up call". Påverkan på de slutna modellerna var överdriven, men Kina tog ledningen inom öppna modeller och öppen källkod för AI.

De bästa öppna modellerna just nu är nästan alla kinesiska: DeepSeek-V3.2, Moonshot AI Kimi-K2, THUDM GLM-4.5, Alibaba Qwen3, tillsammans med Gemma från Google och GPT-OSS från OpenAI. Att de är smartast på programmering och engelska betyder dock inte alltid att de är bäst på svenska. Om ditt företag kör ett eget projekt på svenska så finns det anledning att testa andra, eller kontakta oss på Tenfifty så hjälper vi till!

"Agenter blir mogna"

Delvis rätt. Infrastrukturen mognade definitivt. Anthropics Model Context Protocol (MCP) blev de facto-standard för att koppla AI till externa system när det började stödjas även av OpenAI och Google. OpenAI lanserade webbläsar-agenten Operator i januari. Det kinesiska Manus nådde $100 miljoner i årlig intäkt på åtta månader innan Meta köpte dem för över $2 miljarder. "Computer use", alltså att AI kan se och interagera med din skärm blev något som fler kunde testa. Jag har faktiskt fått nytta av det just i webbläsaren några gånger. Men... de flesta av oss använder fortfarande inte agenter i vårt dagliga arbete. Tekniken finns, men det har inte varit tilläckligt moget än. För företag är det nu tillräckligt moget, men de flesta tidiga företagsprojekt som kallar sig agenter verkar vara mer marknadsföring än verklig agentiskhet.

"Video blir bättre men inte professionell än"

Rätt. Sora 2, Veo 2, och diverse andra verktyg kan nu generera imponerande klipp. Men konsistens mellan scener – samma person, samma objekt – är fortfarande svårt. Hobbyfilmer med AI-genererade scener är vanligare och dyker upp titt som tätt i social media, men Hollywood använder det ännu inte.

"Livslångt lärande saknas"

Fortfarande rätt, tyvärr. Modellerna är fortfarande kristaller frusna i tiden. Efter träningen lär de sig inget nytt. Minnes-features har blivit vanligare, men det är i grunden RAG, textsökning i sparade konversationer, inte riktigt lärande. Mer om detta i del 2!

AI matematikerar

Det som mer i tysthet definierade 2025 för framtiden är vad som hände inom matematik. För de som inte har Terence Tao och Grigorij Perelman (som, trots att han gick under jorden för snart 20 år sedan, tydligen jobbar med nanoteknik i Sverige, så håll ögonen öppna!) som husgudar är det kanske inte naturligt att reflektera dels över hur svårt det är att automatisera och dels över hur användbart matematik är. Nya resultat inom matematik är grunden för all vetenskaplig och teknisk utveckling och även grunden till fortsatt AI-utveckling. Curry-Howard-isomorfismen säger dessutom att bevis är program, så att kunna generera bevis i världsklass är i princip likt att uppfinna nya mjukvaru- eller AI-algoritmer i världsklass, men med olika kunskapsdomäner.

I juli tävlade både Google DeepMind och OpenAI (inofficiellt) på International Mathematical Olympiad, världens mest prestigefyllda matematiktävling för unga. Båda nådde guldmedalj-standard med 35 av 42 poäng. IMO-presidenten kallade lösningarna "häpnadsväckande tydliga, precisa och lätta att följa."

Två månader senare tog Google guld även på ICPC: International Collegiate Programming Contest.

Under andra halvan av året var dock den stora diskussionen Erdős-problemen. Paul Erdős var en legendarisk ungersk matematiker som efterlämnade hundratals olösta problem, många med pengapriser. Under hösten började AI-system systematiskt lösa dessa. De första lösningarna visade sig vara sådana som redan var publicerats i skymundan, men inte katalogiserats officiellt. De misstogs först som helt nya lösningar, vilket ledde till att några matematiker sade att AI för matematik inte är på riktigt. Gary Marcus, den mest kända språkmodellskritikern, skrev skadeglatt "Att lösa en massa olösta Erdős problem hade varit en stor grej om det var sant". Yann LeCun, en av de största AI-pionjärerna och Metas före detta AI-chef, kallade det hela "embarrassing". LeCun är känd skeptiker till att de stora språkmodellerna kommer kunna tas längre än de redan gjort och tror i stället på sin egen världsmodell-design, JEPA, men per i dag ser det som LeCun uttalade sig om mycket mindre genant ut.

Allt eftersom månaderna gick så blev det allt svårare att förneka att det skedde riktig matematisk kreativitet. I december löste AI-systemet "Aristotle" från Harmonic självständigt Erdős-problem #124, ett problem som stått öppet i 30 år. Det tog sex timmar att hitta beviset och en minut att verifiera det i Lean. Ingen människa var inblandad.

Sedan nyår har minst tre nya Erdős-problem lösts av GPT-5.2 Pro och även dessa har verifierats vara tidigare olösta. Här är t.ex en helt färsk artikel som presenterar arbetet från en kombination av GPT-5.2 Pro och Aristotle. Trots detta dessa första steg är det fortfarande med matematik som med programmering, det blir bättre när människa och maskin samarbetar. Fieldsmedaljören Terence Tao dokumenterar på senare tid noggrant sina AI-samarbeten.

Kodvibbar

Bevisföring och programmering är alltså liknande aktiviteter och OpenAI-medgrundaren Andrej Karpathy myntade i februari begreppet vajbkodning för att beskriva vad man vill på naturligt språk och låta AI skriva koden. Collins Dictionary utsåg det till årets ord.

Den inledande skepcismen håller, precis som med matematiken, långsamt på att brytas ned. 90% av utvecklare använde enligt DX AI-kodverktyg i Q4 2025: “DX's Q4 2025 report reveals 91% AI adoption among 135000+ developers, 3.6 hours saved weekly, and mixed quality impacts". Det är svårt att mäta hastighet och kvalitet och olika studier har fått olika resultat, men i Q4 var alltså skillnaden med och utan AI ännu inte överväldigande stor. Jag förväntar mig att i Q4 2026 kommer modellerna vara så mycket bättre och utvecklarna kommer ha bättre process för att jobba med dem, så att man pratar om 50% eller så. Det är också viktigt att se skillnad på existerande kodbaser, som är något svårare att koppla AI på, och nya. Y Combinator rapporterade att 25% av deras Winter 2025-startups hade kodbaser som var 95% AI-genererade.

Min egen erfarenhet bekräftar detta. Sedan Claude Opus 4.5 skriver jag nästan aldrig bokstäverna i koden själv längre. Jag promptar, itererar, granskar och svär över dumheter, men jag skriver inte. Boris Cherny, som uppfann Claude Code för ett år sedan, skrev i december att han han under senaste månaden inte skrivit några commits själv. Allt han bidragit till Claude Code var skrivet av Claude själv. Deras senaste version för icke-programmerare, Claude Cowork, skrevs också helt och hållet av Claude.

Samtidigt faller kostnaden för automatisk intelligens, speciellt för det som är mest avancerat. Epoch AI visar att priset för att nå en given prestandanivå faller med 10-100x per år beroende på nivå. På ARC-AGI specifikt har kostnaden för det resultat som var bäst för ett år sedan fallit 400x. Från o3:s $3440 per fråga till bråkdelar av det i dag.

Detta är, analogt med matematiken, inte samma sak som att programmerare blir överflödiga. Det handlar snarare om att rollen förändras från att skriva kod till att sätta den övergripande planen, orkestrera AI-verktyg, granska output, och hantera de delar som kräver domänkunskap eller bredare omdöme. Det finns fortfarande utvecklare som inte tror på att det där med AI kommer bli något, men de blir allt färre. Och de har fel.

Del 2 kommer om en vecka och handlar om samhällspåverkan, vad som fortfarande saknas och förutsägelser för 2026.